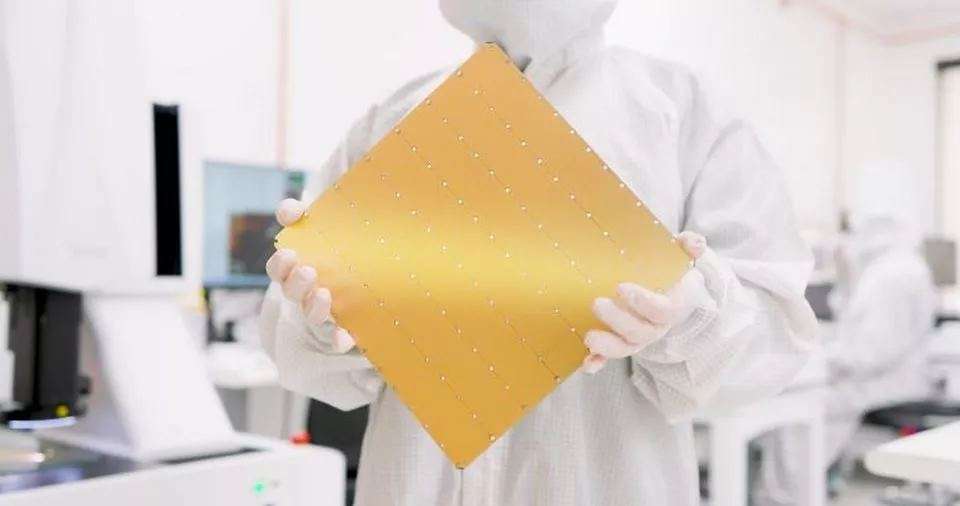

Компания Cerebras Systems представила третье поколение чипа WSE-3, оснащённое 900 000 ядрами, оптимизированными для искусственного интеллекта (ИИ), способными обучать AI-модели с до 24 триллионами параметров. Этот чип является самым крупным ИИ-чипом в мире, содержащим триллионы транзисторов.

С момента выпуска своего первого чипа Wafer Scale Engine (WSE), Cerebras демонстрирует стремительное развитие, и сейчас их процессор третьего поколения предлагает поразительные характеристики благодаря его внушительным размерам, как отмечает WCCF Tech в своём обзоре. Чип WSE-3, как и предполагает его название, представляет собой целую кремниевую пластину, и на этот раз Cerebras делает ставку на AI-манию с впечатляющими характеристиками:

Xарактеристики WSE-3

- 4 триллиона транзисторов;

- 900 000 AI-ядер;

- 125 петафлопс пиковой AI-производительности;

- 44 ГБ встроенной SRAM памяти;

- 5-нм процесс TSMC;

- поддержка внешней памяти: 1,5 ТБ, 12 ТБ или 1,2 ПБ;

- обучение AI-моделей с до 24 триллионами параметров;

- размер кластера до 2048 систем CS-3.

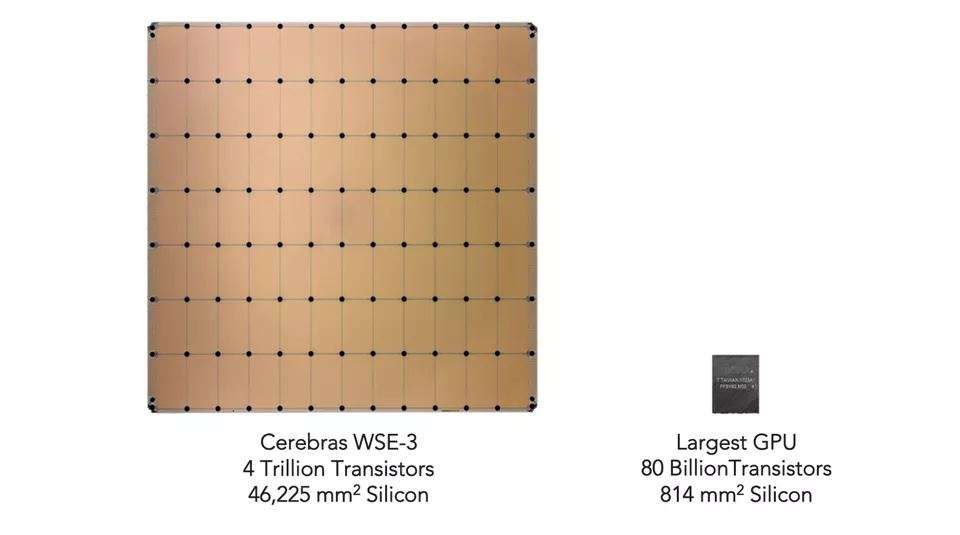

Размер матрицы чипа WSE-3 составляет 46 225 мм², что в 57 раз больше, чем у Nvidia H100 с его размером в 826 мм². Оба чипа произведены по 5-нанометровому процессу TSMC. Несмотря на то что H100 считается одним из лучших AI-чипов на рынке с его 16 896 ядрами и 528 тензорными ядрами, он меньше по размеру по сравнению с WSE-3, который включает 900 000 оптимизированных для AI ядер, или в 52 раза больше.

WSE-3 также демонстрирует впечатляющие показатели производительности: 21 петабайт в секунду пропускной способности памяти (в 7000 раз больше, чем у H100) и 214 петабит в секунду на Fabric (в 3715 раз больше, чем у H100). Чип включает 44 ГБ встроенной памяти (в 880 раз больше, чем у H100).

По сравнению с WSE-2, новый WSE-3 предлагает в 2,25 раза больше ядер (900 000 против 400 000), в 2,4 раза больше SRAM (44 ГБ против 18 ГБ) и значительно выше скорости соединения, всё это в рамках того же размера пакета. Кроме того, он содержит на 54% больше транзисторов (4 триллиона против 2,6 триллиона).

Чем же ценен весь этот аппаратный потенциал? Чип, разработанный первостепенно для ИИ, предлагает пиковую производительность в 125 PFlops. Для сравнения, Nvidia H100 предлагает около 3958 TFlops, или примерно 4,0 PFlops пиковой AI-производительности, что дает увеличение примерно в 31,25 раза.

Чип также предлагается в наборе конфигураций с внешней памятью, варьирующейся от 1,5 ТБ, 12 ТБ до 1,2 ПБ. С таким количеством мощности в одном чипе, он может обучать AI-модели с до 24 триллионами параметров.

Дополнение WSE-3

В дополнение к WSE-3, Cerebras Systems анонсировала свою суперкомпьютерную систему CS-3 AI, которая может обучать модели, в 10 раз больше, чем GPT-4 и Gemini, благодаря огромной памяти. CS-3 AI предназначена как для корпоративных клиентов, так и для хайперскейлеров, предлагая значительно более высокую эффективность по сравнению с современными GPU.

64 таких системы CS-3 AI будут использоваться для питания суперкомпьютера Condor Galaxy 3, который будет предлагать 8 экзафлопс вычислительной производительности для ИИ, удваивая производительность системы при той же мощности и цене.

Цены и наличность чипов WSE-3 пока не объявлены, но ожидается, что они будут стоить значительно меньше, чем 25-30 тыс. долларов, которые Nvidia просит за GPU H100.